Добрый день. Дмитрий! Спасибо за видео.

Скажите вы встречали где-нибудь очень подробное Руководство по внутренней перелинковке для интернет-магазинов (от сбора семантики, анкор-лист, и какие доступные программы есть в этой области)?

Еще стоит ли использовать технологию перелинковки семантический кокон?

Если Вы знаете, что такое семантический кокон, то мои советы Вам не нужны ![]()

И нет, подробного руководства нет. Есть разной степени полезности видео на Youtube и множество мнений.

Лично я под каждый сайт составляю свой план прелинковки в зависимости важности страниц.

Как можно перенести часть страниц с одного сайта на другой и при этом не навредить тому сайт с которого эти страницы будут удаляться?

Если я правильно понял, то это означает переезд сайта на новый домен, и тогда лучший выход - постраничный 301 редирект.

нет не сайта а части страниц. Просто раздел разросся и стал доминировать над общей тематикой. Задача перенести страницы этого раздала сделав другой сайт. Волнует вопрос если удалять страницы (уже было такое в обсуждениях по поводу проданного товара) это же негативно скажется на сайт если поисковик обнаружит что страницы отвечают 404. посетители в данном случае мало интересуют т к контент практически не посещаемый … и если он просто пропадет на сайте ничего страшного.

постраничный 301 редирект через какой инструмент можно сделать?

Постраничный редирект делается в файле .htaccess на хостинге.

я наивно полагал, что это можно сделать ресурсами карта … но там редирект только в пределах одного домена

Добрый день!

Подскажите как убрать ?security_hash= из ссылок, каждый день вылезет в вебмастере что появились новые ссылки.

В robots.txt

User-agent: * и User-agent: Google

Disallow: /?*

User-agent: Yandex

Clean-param: security_hash

Спасибо огромное.

Антикейс.

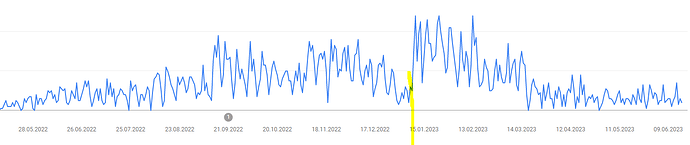

Один сайт начал работать с мая 2022 года. В начале к нему были подклеены десяток разных дропов, в том числе и с нерелевантными анкорами. 12.01.23 владелец решил, что это позор и фу такое клеить, и отклеил. Через месяц трафик из ПС Google начал падать.

Сейчас я пытаюсь восстановить трафик путем покупки более релевантных (или хотя бы менее нерелевантных) дешевых дропов и многоуровневыми прокладками с прогонами Хрумером.

Но восстановить быстро точно не получится, это очень постепенный процесс.

Подскажите пожалуйста, никак не приду к решению стоит ли открывать к индексации вариации товара. Каталог весь с вариациями соответственно ссылки вариаций имеют вид ?variation_id= но они все неканонические, тк дя каждой вариации есть основная карточка без параметра ?variation_id= в url.

Так вот в вебмастере поcтоянно вижу что эти url ?variation_id= то включаются в поиск то исключаются как неканонические. Вечный процесс получается.

С точки зрения SEO их (вариации) лучше оставить или скрыть от индексации?

Например Disallow: *?variation_id*

С практической точки зрения смысловой нагрузки в конкретной вариации для поиска мало, т.к. вариация от основной карточки отличается второстепенными в моей нише параметрами типа размер или наполнитель. С другой стороны поисковик как бы видит что товаров много (если вариации открыты).

Буду благодарен за совет.

Не нужны никакие страницы с get-параметрами в индексе, они сразу становятся дублями.

Для User-agent: * и для User-agent: Googlebot (если он есть) используйте директиву

Disallow: /?*

Для User-agent: Yandex тоже можно, но лучше вместо Disallow: /?* использовать

Clean-param: variation_id

А ещё лучше заказать технический аудит и, кроме проверки по 150 параметрам получить и новый robots.txt ![]()

Спасибо за ответ. Про дубли знаю, параметры закрыты все, а открытые вариации дублей не давали т.к. присутствует тег canonical в них.

User-agent: *

Disallow: *?selected_section*

Disallow: *?show_not_found_notification*

Disallow: /*collection_product

Disallow: /search/

Disallow: /variant

Disallow: /*wishlist.delete

Disallow: /*attachment

Disallow: /*items_per_page

Disallow: /app/

Disallow: /store_closed.html

Disallow: /*?subcats*

Disallow: *product_id*

Disallow: /*?match*

Disallow: *features_hash*

User-agent: Yandex

Clean-param: combination&match&subcats&pcode_from_q&pshort&pfull&pname&pkeywords&search_performed&q&dispatch&features_hash&product_id&post_redirect_url&promotion_id&page&sort&sort_by&sort_order&layout&return_url&block&position&s_layout&redirect_url&utm_sourse&frommarket&items_per_page&with_images&selected_section&clid&prev_url&n_items&show_not_found_notification&utm_medium&utm_campaign&utm_content&utm_term&block&source®ion®ion_name&placement&roistat&rf_parent_post_id&utm

Clean-param: &object_type&object_id&obj_prefix&route&tag_id&limit&path&variation_id&sl&product_review_id&variant_id&manufacturer_id&category_id&post_id&order&abt_in_popup&cookies_accepted&page_id&template&frmgrably

Host: https://домен

Sitemap: https://домен/sitemap.xml

у меня щас такой стоит, насколько правильный?! ![]()

Возьмите у Дмитрия техпроверку сайта. Он там и роботс нафаршированный сделает. Очень рекомендую!

если в вариациях нету изменений в title - тогда это дубли, значит нужно запретить к индексации.

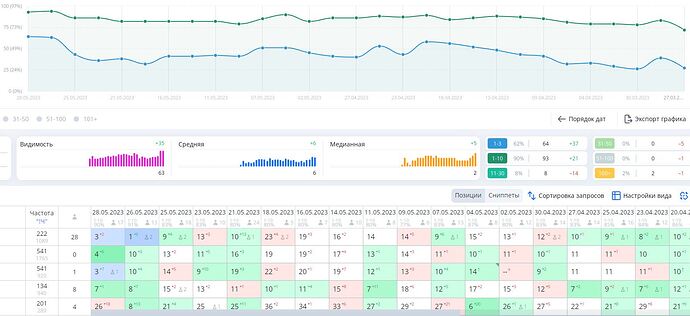

Вспомнил, у меня же кейсы есть.

Вот, например.

Выполненные работы: технический аудит, конкурентный анализ и внедрение коммерческих факторов и контента, необходимого для ранжирования, проработаны юзабилити и конверсия, уточнена региональность, исправлена структура, расширена семантика, устранена каннибаллизация, все категории проработаны по текстовой релевантности, подклеен возрастной дроп + многоуровневые прокладки, ну и небольшой допинг ПФ.

Результат на табло.

Мои принципы работы: долго, нудно, зато дорого

С Merchant Center кто нибудь работал? есть толк с него если добавить фид?