Подскажите, а как можно это сделать ?

это не панацея, и все поисковики говорят, что robots - это рекомендация, которой они могут и не следовать. Может быть ко мне ходит какой-то неправильный робот со сбитой программой, но часть из закрытых страниц в robots он сначала обходит, а на следующий день вычищает из базы согласно правилам.

Да вы правы ) но в индексе страниц закрытых в роботсе мы не встречали

В гугл вебмастере

Спасибо, посмотрю!)

Здравствуйте, скажите пожалуйста если я отредактирую данные строки на свои достаточно ли этого будет или кроме этого еще что-то нужно менять?

эта

эта и вот эта

ну и тут ))

Вы привели три одинаковых строчки? А что хотели то?

достаточно для чего?

У меня выдает ошибку http://joxi.ru/KAxZ85otwN9RYm

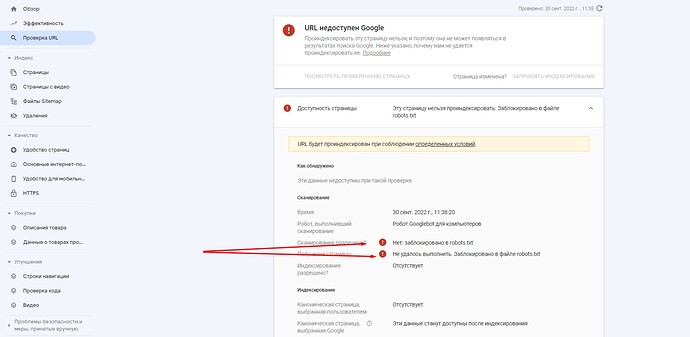

Не могу толком разобраться в файле robots.txt пишет заблокировано. А вот и сам robots.txt

User-agent: *

Disallow: /app/

Disallow: /upgrades/

Disallow: /404.html

Disallow: /cls.php

Disallow: /init.php

Disallow: /php.ini

Disallow: /store_closed.html

Disallow: /login

Disallow: /cart/

Disallow: /checkout/

Disallow: /compare/

Disallow: /kategoriya-korzina/

Disallow: /arhiv/

Disallow: /wishlist/

Disallow: *?*

Disallow: *admin.php

User-Agent: Yandex

Disallow: /app/

Disallow: /upgrades/

Disallow: /404.html

Disallow: /cls.php

Disallow: /init.php

Disallow: /php.ini

Disallow: /store_closed.html

Disallow: /login

Disallow: /cart/

Disallow: /checkout/

Disallow: /compare/

Disallow: /kategoriya-korzina/

Disallow: /arhiv/

Disallow: /wishlist/

Disallow: *admin.php

Disallow: *woff?*

Clean-param: combination&match&subcats&pcode_from_q&pshort&pfull&pname&pkeywords&search_performed&q&dispatch&features_hash&product_id&post_redirect_url&promotion_id&page&sort&sort_by&sort_order&layout&return_url&block&position&s_layout&redirect_url&utm_sourse&frommarket&items_per_page&with_images&selected_section&clid&prev_url&n_items&show_not_found_notification&utm_medium&utm_campaign&utm_content&utm_term&block&source®ion®ion_name&placement&roistat&rf_parent_post_id&utm

Clean-param: &object_type&object_id&obj_prefix&route&tag_id&limit&path&variation_id&sl&product_review_id&variant_id&manufacturer_id&category_id&post_id&order&abt_in_popup&cookies_accepted&page_id&template&frmgrably

Sitemap: https://Мой доменsitemap.xml

User-agent: Googlebot

Disallow: /app/

Disallow: /upgrades/

Disallow: /404.html

Disallow: /cls.php

Disallow: /init.php

Disallow: /php.ini

Disallow: /store_closed.html

Disallow: /login

Disallow: /cart/

Disallow: /checkout/

Disallow: /compare/

Disallow: /kategoriya-korzina/

Disallow: /arhiv/

Disallow: /wishlist/

Disallow: *?*

Disallow: *admin.php

Sitemap: https://Мой домен/sitemap.xmlА какая страница заблокирована то? url у нее какой?

Вот мой

User-agent: *

Disallow: /app/

Disallow: /store_closed.html

Disallow: *admin.php

Disallow: /login

Disallow: *?*

Host: https://www.hit-dekor.ru

Sitemap: https://www.hit-dekor.ru/sitemap.xm

host и sitemap достаточно один раз указать в конце отдельным блоком

кстати, у меня гугл наоборот, сообщает, что проиндексировал страницы ВОПРЕКИ тому, что страницы заблокированы в robots…

PS ну и еще - это файл robots, или через админку карта? если через админку карта - физический файл удален?

А кнопка Посмотреть проверенную страницу - показывает что именно за страница?

Или какой url проверяли - если это ручная проверка?

Могу ли я написать вам в личку?

Скину домен и ссылку на сам robots.txt щас опять что-то не то пропишу. Если вам не трудно дайте пожалуйста готовый текст который просто нужно будет вставить в Веб сайт-Seo-Robots.txt

Не реагирует

Нашел, вот ссылку эту показывает dispatch=tags.view&tag=%D0%90%D0%BD%D1%82%D0%B8%D0%BF%D0%B5%D1%80%D1%81%D0%BF%D0%B8%D1%80%D0%B0%D0%BD%D1%82-%D0%BA%D0%B0%D1%80%D0%B0%D0%BD%D0%B4%D0%B0%D1%88

так вот это правило

Disallow: *?*

его и запрещает

PS давайте я попозже отпишу, сейчас ехать надо. Вкратце, если нужны страницы тегов - нужен модуль @ecomlabs SEO правила, прописать ЧПУ для страниц тегов - и они не будут исключаться этим правилом

Просто скопировал что выдало тут и вставил это в Веб сайт-Seo-Robots.txt и сохранил.

Алекс, я не знаю всех этих нюансов, не могли бы вы мне скинуть готовый правильный robots я его вставлю сохраню и забуду про него ))

Хорошо, без проблем.

Спасибо большое вам, хорошей дороги и приятного вечера.

одного robots недостаточно, если вы хотите отдавать не только товары и категории со страницами, но и сео страницы - теги, страницы фильтров и комбинаций фильтров, отзывы, скидки итп