Эксперты robots.txt просьба помочь!

Какой должен быть Clean-param?

Clean-param: combination&match&subcats&pcode_from_q&pshort&pfull&pname&pkeywords&search_performed&q&dispatch&features_hash&product_id&post_redirect_url&promotion_id&page&sort_by&sort_order&layout&return_url&block&position&s_layout&redirect_url&utm_sourse&frommarket&items_per_page&with_images&selected_section&clid&prev_url&n_items&show_not_found_notification&utm_medium&utm_campaign&utm_content&utm_term&block&source®ion®ion_name&placement&roistat&action&order_id&category_id&hint_q&product_review_id&hl

Если не используете UTM метки можете их удалить из перечня

У нас указано следующим образом:

Clean-param: utm_ya_campaign

Clean-param: gtm_debug

Clean-param: yabizcmpgn

Clean-param: utm_candidate

Clean-param: utm

Clean-param: variation_id

Clean-param: etext

Clean-param: yadclid

Clean-param: utm_referer

Clean-param: features_hash

Clean-param: keyword

Clean-param: matchtype

Clean-param: device

Clean-param: from

Clean-param: items_per_page

Так тоже можно, но много места занимает)) а параметров реально много)

Clean-param: combination&match&subcats&pcode_from_q&pshort&pfull&pname&pkeywords&search_performed&q&dispatch&features_hash&product_id&post_redirect_url&promotion_id&page&sort&sort_by&sort_order&layout&return_url&block&position&s_layout&redirect_url&utm_sourse&frommarket&items_per_page&with_images&selected_section&clid&prev_url&n_items&show_not_found_notification&utm_medium&utm_campaign&utm_content&utm_term&block&source®ion®ion_name&placement&roistat&rf_parent_post_id&utm

Clean-param: &object_type&object_id&obj_prefix&route&tag_id&limit&path&variation_id&sl&product_review_id&variant_id&manufacturer_id&category_id&post_id&order&abt_in_popup&cookies_accepted&page_id&template&frmgrably

Здравствуйте. Подскажите пожалуйста, хочу скрыть малоценные страницы tags,categories-catalog,catalog, promotions, закрыл в robots.txt но это не помогло, я так понимаю из-за того, что они находятся в карте сайта, тут вопрос, как убрать из карты сайта?

И еще, где можно прописать мета-теги (Title, Description) на этих страниц?

robots.txt - это просьба к поисковым системам не индексировать эти страницы.

И Яндекс, и Google достаточно часто их игнорируют.

Жестко закрывать надо в метатег robots с директивой noindex Метатег robots и HTTP-заголовок X-Robots-Tag - Вебмастер. Справка

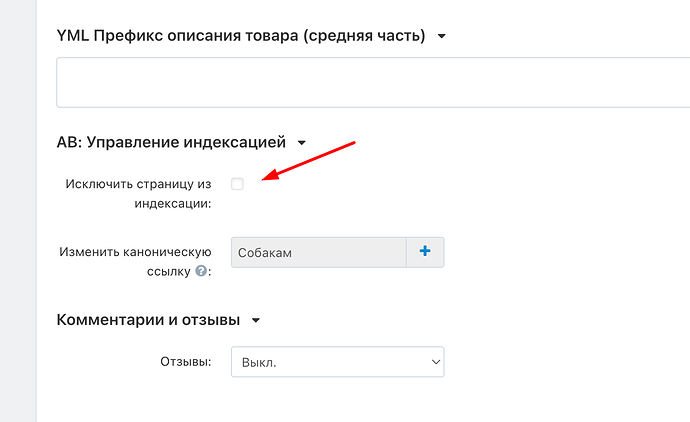

Если есть деньги - купите модуль Управление индексацией Add-ons :: Indexing management

У меня есть этот модуль, подскажите где и как закрыть страницы tags,categories-catalog,catalog, promotions?

А у меня нет, поэтому не знаю ![]()

У меня сайту на CS-Cart лет 7, мусора нет в выдаче, кеш не пухнет. Но я не пользуюсь clean-param вообще, тем более что он только для Яндекса значение имеет. Вот что в роботс у меня

Host: https://траливали.ру

User-agent: *

Disallow: /app/

Disallow: /store_closed.html

Disallow: /login/

Disallow: /*dispatch=

Disallow: /*subcats=

Disallow: /*features_hash=

Disallow: /*items_per_page=

Disallow: /*sort_by=

Disallow: /*aoc=

Disallow: /*page=

Clean-param: layout